Was ist eigentlich Edge Computing? Kennen Sie den Begriff und wenn ja, was verbinden Sie damit?

Und um das Ganze möglichst einfach zu beschreiben, fangen wir mit einem Beispiel aus der Industrie an.

Ein modernes Industrieunternehmen ist mit etlichen Maschinen ausgestattet. In Produktionshallen und Lagerräumen werden mit Sensoren laufend Daten wie Temperaturen, Luftfeuchtigkeit, Drehzahlen oder Füllstände ermittelt.

Hinzu kommen die Arbeitszeitprotokolle der Mitarbeiter, Maschinendiagnosen und Messungen für die Qualitätskontrolle.

Maschinen und Sensoren produzieren Unmengen an Daten in den Fabriken und Werkhallen. Durch Edge Computing verarbeitet man diese Daten lokal und filtert, noch bevor sie zu den zentralen Rechenzentren oder in die Cloud geschickt werden.

Das spart nicht nur Bandbreite, sondern auch Zeit und Nerven.

Was bringt es noch?

Nun, Edge Computing sorgt auch für eine robuste IT-Infrastruktur, da es dezentral arbeitet. Dadurch erhöht sich automatisch die Sicherheit und der Datenschutz.

Und: Die Daten bleiben innerhalb des Unternehmensnetzwerks – dank cleverer Edge Gateways.

Aber das ist noch nicht alles!

Die Unternehmen können mit Edge Computing ihre Rechenleistung flexibel skalieren, je nach Bedarf. Das bedeutet verbesserte Überwachung, Wartung und Leistungsoptimierung für die Anlagen. Es ermöglicht die nahtlose Integration und Verarbeitung von IoT-Daten in Echtzeit.

Würde man hier auf klassische Cloud-Lösungen setzen, müssten alle diese Informationen zunächst über das Firmennetz und dann übers Internet zum Hauptsitz des Unternehmens übertragen werden.

Alleine die dafür benötigte Bandbreite und die Cloud-Kapazitäten wären viel zu hoch. Nicht zu vernachlässigen sind zudem die langen Latenzzeiten, die Echtzeitreaktionen verhindern.

Gerade in der Fertigung können solche Latenzzeiten verheerende Folgen haben.

Die Daten werden bereits am Rand in Edge Nodes aggregiert und nur noch in abgeleiteter Form zur zentralen Cloud übertragen. Es gibt also zwei Vorteile:

- Man spart man sich einen großen Teil des Datenvolumens.

- Und was noch wichtig ist: Die Reaktionszeiten lassen sich minimieren.

Die direkt vor Ort durchgeführten Analysen und Auswertungen machen auch sehr schnelle Reaktionen möglich. Arbeiter und Instandhalter werden bei beginnenden Maschinenpannen sofort alarmiert.

Außerdem wichtig:

Die Produktionsprozesse lassen sich in Echtzeit optimieren. Ausfälle und Qualitätsprobleme können durch vorausschauende Instandhaltung vermieden werden. Das spart dem Unternehmen immensen Aufwand und Kosten.

Edge Computing hat sich so als ideale Lösung für solch datenintensive Produktionsumgebungen bewährt. Und es ist oft effizienter und kostengünstiger als alternative Möglichkeiten zur Datenverarbeitung.

Wie es zum Edge Computing kommt

In den letzten Jahren hat sich unsere digitale Lebenswelt immer mehr in Richtung Mobilität und Vernetzung entwickelt.

Immer mehr Geräte und Dinge des Alltags sind heute mit dem Internet verbunden und tauschen große Datenmengen aus. Und das laufend.

Sei es das Smartphone, das vernetzte Auto oder industrielle Maschinen – überall werden permanent Sensordaten erzeugt und Analysen in Echtzeit benötigt.

Stellen Sie sich vor, diese Datenflut wollte man mit herkömmlichen Modellen verarbeiten. Das wäre kaum machbar.

Denn je weiter die Daten übertragen werden müssen, desto höher sind die dabei auftretenden Latenzzeiten.

Gerade für Anwendungen, die auf Echtzeit-Reaktionen angewiesen sind, sind solche Verzögerungen jedoch ein Problem.

Genau hier setzt Edge Computing an.

Im Gegensatz zu zentralisierten Cloud-Systemen werden die Daten beim Edge Computing dezentral und möglichst nah an der Quelle verarbeitet, bevor sie übertragen werden.

Statt alles in einen einzelnen Cloudblock zu packen und von dort zu verteilen, werden die Daten und Anwendungen näher zum Rand, also „Edge“ des Netzwerks herangeholt.

Konkret bedeutet Edge Computing also, dass Datenverarbeitung und -analyse dort stattfindet, wo die Daten erzeugt werden – etwa in Filialen, Fabriken, Kraftfahrzeugen oder auch einfach im heimischen IoT-Netzwerk.

Mittels leistungsstarker Edge-Server direkt vor Ort können Unternehmen und Organisationen so Erkenntnisse in Echtzeit gewinnen und schnell auf Ereignisse reagieren, ohne erst gigantische Datenmengen in eine Cloud schieben zu müssen.

Die Vorteile liegen klar auf der Hand.

Vor allem zeitkritische Anwendungen wie autonomes Fahren, Echtzeit-Analysen in der Produktion oder die Fernsteuerung von Maschinen werden durch Edge Computing erst möglich.

Darüber hinaus erlaubt es die dezentrale Speicherung auch, sensible Kundendaten besser vor Hackerangriffen oder Datendiebstahl zu schützen.

Seit wann gibt es Edge Computing?

Der Begriff „Edge Computing“ kam Anfang der 2010er Jahre auf, als Technologieführer wie Cisco das Potenzial dieser dezentralen Infrastruktur erkannten.

Doch die Wurzeln dieser Idee gehen noch viel weiter zurück.

Bereits in den 1990er Jahren kam mit Content Delivery Networks (CDNs) ein Vorläufer auf, der Inhalte näher zum Nutzer brachte, um Wartezeiten zu reduzieren.

Heute ist Edge Computing eine der wichtigsten Trendthemen in der Technologiebranche.

Mit Edge Computing lassen sich die Vorteile des mobilen und vernetzten Arbeitens optimal kombinieren.

Statt die Cloud als Alleskönner zu sehen, werden Rechenressourcen dorthin gebracht, wo sie effektiv nutzbar sind. So steigert man die Produktivität und Effizienz in zahlreichen Anwendungsbereichen.

Kein Wunder, dass renommierte Analysten heute dem Edge Computing eine erfolgreiche Zukunft vorhersagen.

Aber nun geht es erst einmal um die Grundlagen und Funktionsweise von Edge Computing. Schon heute profitieren einige Unternehmen bereits von den Vorteilen.

Die technologischen Grundlagen

Technisch gesehen basiert Edge Computing also auf dem Prinzip, Datenverarbeitung dort durchzuführen, wo die Daten erzeugt werden – nämlich am Rand des Netzwerks, dem sogenannten „Edge“.

Herzstücke einer solchen Edge-Infrastruktur sind leistungsstarke Edge-Server, die direkt vor Ort in Fabriken, Filialen oder anderen Einrichtungen aufgestellt werden.

Diese Edge-Server kommunizieren über eine sichere Verbindung mit Cloud-Rechenzentren und übernehmen einen Großteil der Datenverarbeitung und Komprimierung. Gleichzeitig stellen sie ihre Ressourcen auch lokal vernetzten Endgeräten und IoT-Sensoren über Wireless- oder Feldbus-Technologien zur Verfügung.

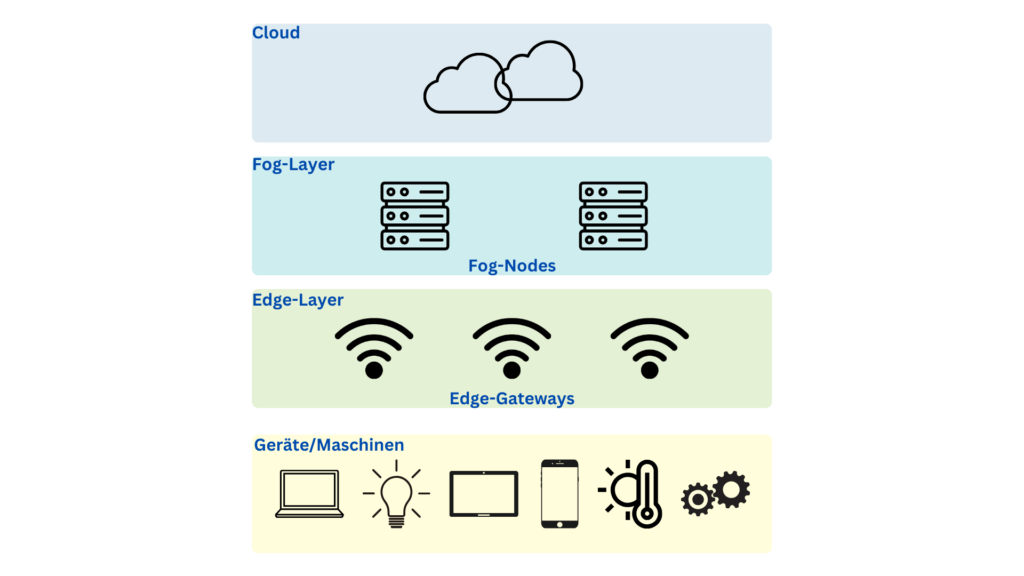

Die Edge-Server sind also quasi Vermittler zwischen der Cloud und den Geräten und Maschinen vor Ort.

Wichtige Komponenten sind sogenannte Edge Nodes. Das sind in der Regel kleine Server oder Computer, die unmittelbar neben den Datenquellen aufgestellt werden. Das können Maschinen, Fabrikräume oder andere Einrichtungen sein.

Ihre Aufgabe ist es, die anfallenden Daten vorzuverarbeiten und bei Bedarf in Echtzeit auszuwerten.

Über spezielle Gateways oder Clients, die als Schnittstelle dienen, kommunizieren die Edge Nodes dann mit den Endgeräten. Zum Beispiel stellt ein Gateway die Netzwerkverbindung für mehrere IoT-Sensoren her. So können große Datenmengen bereits auf Ebene dieser Edge Nodes gefiltert und komprimiert werden, bevor sie zur Cloud gelangen.

Durch diese dezentrale Struktur bleibt die Latenzzeit sehr gering, da die Rechenleistung nah an der Datenerfassung erfolgt.

Was ist die Netzwerklatenz und warum ist sie wichtig?

Unter Netzwerklatenz versteht man die Zeit, die Datenpakete für die Übertragung vom Absender zum Empfänger im Netzwerk benötigen.

Sie sagt also etwas darüber aus, wie schnell oder langsam Informationen übertragen werden.

Je geringer die Latenz ausfällt, desto besser lässt es sich kommunizieren. Hohe Latenzwerte bedeuten dagegen lange Wartezeiten und Verzögerungen beim Datenaustausch.

Für Unternehmen ist eine niedrige Netzwerklatenz sehr wichtig. Denn nur so lassen sich effiziente Geschäftsprozesse realisieren, sei es im Bereich Vertrieb, in der Fertigung oder bei der Zusammenarbeit über verschiedene Standorte hinweg.

Auch für rechenintensive Echtzeit-Anwendungen wie Videokonferenzen, Virtual Reality oder Wettermodellierung ist gerade bei großen Datenmengen eine geringe Latenz entscheidend.

Steigen die Verzögerungszeiten zu stark an, kommt es schnell zu Leistungseinbußen oder im schlimmsten Fall zum kompletten Ausfall mancher Anwendungen.

In der Industrie können hohe Latenzzeiten Stillstände und Ausfälle von Maschinen oder Fertigungseinrichtungen verursachen.

Um niedrige Latenzzeiten zu erzielen, kommt es daher auf eine leistungsfähige Netzinfrastruktur sowie moderne Technologien wie 5G sowie Edge Computing an. Nur so bleiben digitale Prozesse dort am Laufen, wo es drauf ankommt.

Die Latenzzeit ist also ein wichtiger Faktor für schnelle und reibungslose Kommunikation – sowohl zwischen Maschinen als auch zwischen Menschen.

Doch zurück zur Technik des Edge Computings:

In der Cloud angekommene Datenpakete beinhalten dann nur noch die notwendigen Informationen. Dies ermöglicht High-Speed-Analysen und Echtzeitreaktionen selbst bei großen Datenströmen.

Das bereits jetzt an verschiedenen Edge-Standorten verteilte Computing-Modell wird durch den neuen Mobilfunkstandard 5G zusätzlich beschleunigt.

Mittlerweile sind fast alle namhaften IT-Unternehmen wie Cisco, Microsoft, HPE oder IBM mit Edge-Computing-Lösungen on dem Markt vertreten. Das sorgt für einen großen Wachstum dieser Technologie.

Die Entwicklung von Edge Computing

Wie bereits angesprochen, gab es bereits in den 1990er Jahren erste Vorläufer dieser Technologie.

Damals wurden mit Content Delivery Networks (CDNs) erstmals Infrastrukturen aufgebaut, die Inhalte näher an den Nutzer auslieferten. So konnten Verzögerungen beim Herunterladen von Webseiten oder Videos vermieden werden – ein frühes Beispiel für den Edge-Gedanken.

Ein weiterer wichtiger Meilenstein waren Konzepte wie Pervasive Computing und Peer-to-Peer-Overlay-Netzwerke, die in den 2000er Jahren aufkamen.

Sie zielten darauf ab, Rechenressourcen und Speicherplatz dezentral auf Endgeräte zu verteilen, um die Netze zu entlasten. Auch das Sammeln und Vorverarbeiten von Telemetriedaten am Rande des Netzes wurde erstmals umgesetzt.

Und das sind ein paar der wichtigsten Eigenschaften des Edge Computing.

Den endgültigen Durchbruch brachte dann die zunehmende Verbreitung von Cloud Computing. Nun konnte die benötigte IT-Infrastruktur dynamisch und auf Abruf bereitgestellt werden.

Aber dieses Modell arbeitet mit der zentralen Datenverarbeitung. Und damit kam es schon bald an technische und wirtschaftliche Grenzen.

Ein weiterer Erfolgsfaktor für Edge Computing:

Die massenhafte Vernetzung smarter Geräte und Sensoren im Internet der Dinge.

Mit dem enorm wachsenden Datenvolumen wurden die Nachteile zentraler Verarbeitung offensichtlich. Eine weitere Lösung musste her.

Seitdem befindet sich Edge Computing im ständigen Aufwind.

Zukunftsweisende Bereiche wie autonomes Fahren oder Augmented Reality wären ohne die geringen Latenzzeiten nicht möglich.

Anwendungsbereiche und Beispiele

Ein Beispiel wurde gleich zu Beginn des Beitrags genannt.

Eine der wichtigsten Anwendungen ist die Industrie. Es geht hier um die Vernetzung und Überwachung industrieller Produktionsprozesse mithilfe von Edge Computing.

So lassen sich Daten wie Maschinen-Telemetriedaten unmittelbar und vor allem schnell auswerten, um Ausfälle zu vermeiden oder Prozesse zu optimieren.

Sie wissen ja, wie wichtig der Zeitfaktor in diesem Bereich ist.

- Auch der Bereich Smart Cities, also vernetzte digitale Infrastrukturen in Städten, profitiert enorm. Über Edge Nodes verteilt in der Stadt können etwa Verkehrsströme in Echtzeit gesteuert oder Umweltdaten ausgewertet werden.

- Im Handel spielt Edge Computing etwa beim Einsatz mobiler Kassen oder Lagersystemen eine Rolle. So lassen sich Prozesse beschleunigen. Und das Kundenerlebnis verbessert sich.

- Im Gesundheitswesen ermöglicht Edge Computing die Übertragung medizinischer Daten in Echtzeit, zum Beispiel bei Operationen oder bei der Ferndurchführung einer sehr komplexen Diagnostik.

- Im Bereich Smart Home werden immer mehr Geräte wie Alarmanlagen, Unterhaltungselektronik oder Sprachassistenten dezentral über Edge Nodes gesteuert, um schnelle Reaktionen sicherzustellen.

- Im professionellen Sport erlaubt Edge Computing Athleten und Trainern, mittels Körpersensoren Trainingsanalysen in Echtzeit vor Ort durchzuführen.

Edge Computing und das Internet der Dinge

Was haben Edge Computing und das Internet der Dinge (Internet of Things, kurz IoT) miteinander zutun?

Stellen Sie sich die unzähligen vernetzten Geräte vor, mit denen wir tagtäglich in Berührung kommen – von intelligenten Thermostaten bis hin zu medizinischen Sensoren.

Diese Dinge werden stetig smarter.

Und was geschieht mit den vielen Mega- und Gigabytes an Daten, die diese Geräte produzieren? Bisher ging der Trend häufig dahin, die Daten in Richtung Cloud zu senden.

Doch Edge Computing bietet hier einen weitaus besseren Weg. Dadurch, dass man die Daten bereits am Rande des Netzes in der Nähe ihrer Quelle analysiert, sinken die Latenzzeiten enorm.

So können die Geräte in Echtzeit kommunizieren, und die Cloud bleibt entlastet, da keine Rohdaten mehr übertragen werden müssen.

Durch diesen dezentralen Ansatz lässt sich der wachsende Datenstrom des Internets der Dinge hervorragend bewältigen. Vor allem mit dem 5G-Ausbau werden IoT-Anwendungen weiter an Bedeutung gewinnen.

Edge Computing und das Internet der Dinge ergänzen sich also perfekt und ermöglichen komplexe Szenarien wie Smart City, Industrie 4.0 oder autonome Systeme. Und möglicherweise ist genau das die Zukunft: vernetzt und dezentral.

Unterschiede zwischen Edge Computing, Cloud und Fog Computing.

Diese drei Modelle zur verteilten Bereitstellung von IT-Infrastruktur unterscheiden sich hauptsächlich in der physischen Positionierung der Rechen- und Speicherkapazitäten.

Beim Edge Computing sind die Ressourcen dort, wo die Daten entstehen.

Die Cloud hingegen bringt Kapazitäten in Rechenzentren unter, die sich häufig weit entfernt vom Ursprungsort der Daten befinden. Der Vorteil ist die flexible Skalierbarkeit. Es gibt aber auch mögliche Performanzeinbußen durch die Datenübertragung über eine große Distanz.

Genau hier setzt das Fog Computing an.

Es nimmt quasi eine Mittelposition ein. Wären Edge allein überfordert oder die Cloud zu weit weg, kommen hier verteilte Fog-Knoten zum Einsatz.

Sie verarbeiten Daten direkt dort, wo sie anfallen – etwa in smarten Stadtgebieten. Der Fokus liegt auf Effizienz durch Nähe bei großen Datenmengen.

Aus diesem Grund ist Fog Computing auch besonders spannend. Es kombiniert die Vorzüge von Edge und Cloud perfekt miteinander.

In Zukunft wird es darauf ankommen, die für den jeweiligen Anwendungsfall optimale Computing-Form auszuwählen. Es bleibt interessant, wie sich diese Modelle weiterentfalten werden.

Die Voraussetzungen für erfolgreiches Edge Computing

Damit Edge Computing seine Vorteile auch ausspielen kann, gibt es einige wichtige Dinge zu beachten. Hier sind die wichtigsten Voraussetzungen:

Zunächst braucht es Hardware, die robust genug für den rauen Einsatz als Edge-Computer ist. Wird sie draußen betrieben, muss sie den Wettereinflüssen wie Hitze oder Kälte standhalten. Der Staubschutz ist ebenfalls ein wichtiges Thema.

Die Systeme sollten daher lüfterlos und komplett abgedichtet arbeiten können. Nur so überstehen sie lange Einsätze ohne Wartung.

Darüber hinaus benötigt man umfassende Monitoring-Tools, um die dezentralen Installationen immer im Blick zu behalten. Dadurch lassen sich Probleme früh erkennen und beheben.

Idealerweise sind die Systeme relativ ausfallsicher. Aber welche Technologie ist schon perfekt? Probleme können immer wieder auftreten.

Außerdem wichtig:

Die Technik sollte einfach zu installieren und zu handhaben sein. Nicht zu vergessen umfangreiche Benachrichtigungs- und Reporting-Funktionen.

Ganz egal, für welche Software-Plattform man sich entscheidet – mit robuster Hardware und durchdachtem Monitoring legt man die Grundlage für erfolgreiches Edge Computing auch unter schwierigen Bedingungen.

Die Vorteile

Einer der zentralen Vorteile, der sich schon aus der dezentralen Architektur ergibt, sind die sehr geringen Latenzzeiten zwischen Datenaufnahme und -verarbeitung.

Oft werden Echtzeitanwendungen wie die Fernsteuerung von Maschinen, autonomes Fahren oder komplexe AR-Lösungen überhaupt erst möglich. Außerdem macht Edge Computing diese Anwendungen effizienter und energiesparender.

Ein großer Nutzen besteht zudem im Bereich der Bandbreitennutzung und Skalierbarkeit. Durch die Vorverarbeitung am Edge reduziert sich das Datenvolumen auf der letzten Meile massiv.

Netze und die Cloud lassen sich also deutlich entlasten.

Gleichzeitig können Systeme durch simple Skalierung der Edge Nodes viel besser an die steigenden Datenmengen angepasst werden.

Auch in Sachen Sicherheit und Datenschutz bringt die Dezentralisierung große Vorteile mit sich. Sensible Daten speichert man nicht in einer zentralen Cloud. Sie stehen im besten Fall an mehreren Orten zur Verfügung.

Das Risiko für Hacks und Datenklau lässt sich dadurch minimieren. Ein großer Vorteil für die Datensicherheit gerade in kritischen Bereichen.

Außerdem erlaubt Edge Computing eine höhere Verfügbarkeit, da Anwendungen auch lokal genutzt werden können, selbst wenn eine Cloud-Verbindung einmal ausfällt.

Uns so führt Edge Computing zu einer enormen Steigerung von Produktivität, Effizienz und Kosteneinsparungen. Es ist daher kaum verwunderlich, dass führende Analysten von einer sehr rosigen Zukunft dieser Technologie ausgehen.

Herausforderungen und Risiken

Aber es gibt auch Nachteile.

Weil sich beim Edge Computing alles am Rande abspielt:

Sicherheitsupdates müssen häufiger und flexibler verteilt werden als zentral. Dies erfordert ausgefeilte Update-Mechanismen und eine laufende Überwachung.

Sehr Komplex sind auch die Anforderungen an die Kompatibilität und Integration unterschiedlicher Edge-Nodes, Gateways und Cloud-Dienste.

Verschiedene Standards und proprietäre Lösungen können die Interoperabilität erschweren.

Was das Thema Wartung und Überwachung angeht:

Große Mengen an Edge-Knoten machen diese Dinge nicht gerade einfacher. Hier sind standardisierte Managementsysteme notwendig.

Datenschutzfragen aufgrund verteilter Datenhaltung müssen sorgfältig geklärt werden. Nicht zuletzt sind Abhängigkeiten von Cloud-Anbindungen ein Problemfall.

In der Praxis kann es auch Probleme bei der Skalierbarkeit geben. Gleiches gilt für die Kosten der Edge-Infrastruktur.

Edge Computing verursacht also wegen seiner Komplexität auch einen gewissen Aufwand. Nur wer diese Herausforderungen meistert, kann von den Vorteilen nachhaltig profitieren.

Weitere Herausforderungen der dezentralen Infrastruktur

Die dezentrale Infrastruktur macht einen höheren administrativen Aufwand notwendig. Betreibt man statt einer großen Rechenfarm viele kleine Serverstandorte, steigt natürlich auch die Komplexität des ganzen Netzwerks.

Vor allem die kleinen und mittelständischen Unternehmen haben hier noch Nachholbedarf, was Fachwissen und Personal angeht.

Defekte zu beheben, ist schwierig bei fehlender Expertise vor Ort.

Auch die Automatisierung und Standardisierung der Systeme über alle Standorte hinweg ist schwierig umzusetzen. Automatisierte Updates und der reibungslose Datenaustausch machen durchdachte Lösungen notwendig.

Nicht zuletzt ist die physische Absicherung am dezentralen Rand eine besondere Herausforderung. Hier braucht man durchdachte Sicherheitskonzepte.

Aber: Die Potenziale von Edge Computing sind es wert, diese Technik einzusetzen. Mit kluger Systemarchitektur und dem gezielten Aufbau von Wissen lassen sich diese Hürden schrittweise überwinden.

Nebenbei: Was ist proprietäre Software?

Proprietäre Software beinhaltet Programme, deren Nutzung und Weitergabe der Hersteller bestimmt.

Der große Unterschied zu Open Source Programmen ist, dass proprietäre Software nicht frei einsehbar, veränderbar und weiterverbreitbar ist. Stattdessen legt der Entwickler durch Lizenzverträge, Softwarepatente und Urheberrechte fest, wie die Software genutzt werden darf.

Änderungen oder Anpassungen durch Dritte sind in der Regel nicht erlaubt. Auch die Weitergabe etwa durch Verkauf hängt von den Lizenzbedingungen ab.

In der Regel müssen proprietäre Programme kostenpflichtig erworben werden, oft auch gegen wiederkehrende Lizenzgebühren.

Die Serviceleistungen und Aktualisierungen stellt dann üblicherweise der Hersteller bereit.

Für Unternehmen hat proprietäre Software den Vorteil größerer Kontrolle, zum Beispiel was Sicherheitsupdates oder die Wahrung geistigen Eigentums betrifft. Allerdings wird die Flexibilität durch die Abhängigkeit vom Hersteller eingeschränkt.

Das spielt auch beim Edge Computing eine Rolle, womit wir wieder beim Thema wären.

Die Zukunftsaussichten

Durch 5G lassen sich in Zukunft möglicherweise sogar sehr datenintensive Anwendungen wie Cloud Gaming und industrielle Anwendungen auch mobil nutzen.

Mit dem verstärkten Trend zu hybriden Cloud-Modellen werden Multi-Access-Edge-Computing-Plattformen (MEC) für den Mischbetrieb lokaler und öffentlicher Clouds an Bedeutung gewinnen.

MEC vereint geschickt die Vorteile des Edge und Cloud Computing, indem es Rechenleistung gezielt in die Mobilfunknetze auslagert und so die Datenverarbeitung noch näher an das Endgerät rückt. Das ermöglicht extrem kurze Latenzzeiten und ganz neue Anwendungsszenarien speziell für Echtzeitanwendungen.

Autonome Maschinen können auf Edge Computing setzen, um in Echtzeit auf ihre Umgebung zu reagieren. Hier entstehen neue Wertschöpfungsketten rund um Edge- basierte Dienste.

Auch Augmented Reality und virtuelle Welten werden ihren Siegeszug durch MEC-Integration fortsetzen und herkömmliche Unterhaltung für immer verändern.

Edge Computing wird aller Voraussicht nach nachhaltig die Art verändern, wie die Unternehmen ihre IT-Infrastrukturen betreiben und nutzen.

Edge Computing in die Praxis umsetzen

Ein spannendes Thema ist, wie wir Edge Computing durchdacht aufsetzen. Hier sind ein paar Gedanken dazu:

Zunächst geht es darum, die IT genau dort hinzubringen, wo die Daten entstehen. Das können kleinere Server sein, robust und in Schränke eingebaut.

Wichtig ist ein einheitliches Management auch verteilter Infrastruktur. Nur so lassen sich auch viele verschiedene Standorte beherrschen.

Auch hybride Lösungen sind gefragt, die verschiedene Edge-Szenarien abdecken. Der Markt bietet schon gute Grundlagen.

Zu den wichtigsten Dingen zählt aber die Interoperabilität. Nur so lässt sich das Beste aus verschiedenen Komponenten zusammenführen.

Updates und Wartung müssen reibungslos laufen. Eine mögliche Lösung dafür ist die Automatisierung der Wartung, etwa durch automatisch und nach einem Zeitplan durchgeführte Wartungsarbeiten und Updates.

Was kostet Edge Computing?

Die Kosten für die Umsetzung von Edge Computing hängen von verschiedenen Faktoren ab. Hier sind einige davon:

- Größe und Skalierung der Technik

- die Menge an zu erfassenden und zu verarbeiteten Daten

- die geografische Lage des Einsatzortes der Technik

Leider ist Edge Computing meist teurer als Cloud Computing.

Laut einer aktuellen Schätzung von Edge Computing News kostet lokales Edge Computing etwa 35 bis 55 Prozent mehr als Cloud Computing in Kernbereichen, wobei sowohl die Kosten im Vorfeld als auch Betriebskosten für drei Jahre berücksichtigt wurden.

Zusätzliche Kosten können entstehen durch Räume für das Unterbringen der Technik (zum Beispiel Server), den Kühlungsaufwand und das Wartungspersonal.

Die Unternehmen haben zudem die Wahl zwischen der Einrichtung eigener Edge-Clouds oder der Nutzung einer bereits vorhandenen Plattform. Vor allem der Aufbau einer neuen oder erweiterten Infrastruktur ist mit hohen Kosten verbunden.

Individuelle Lösungen mit neuen Räumlichkeiten verursachen deutlich mehr Kosten die Serverhardware und die notwendigen Softwarelizenzen.

Fazit zum Thema Edge Computing

Edge Computing ist also eine der wichtigsten treibenden Kräfte der nächsten technologischen Revolution. Vieles wird aber auch davon abhängen, wie man Herausforderungen wie Sicherheit und Standardisierung löst.

In jedem Fall spannend, diesen innovativen Wandel in den kommenden Jahren weiter zu beobachten.

Die gewaltigen Datenmengen, die durch IoT und Co. entstehen, können gar nicht mehr allein in der Cloud verarbeitet werden. Latenzkritische Anwendungen brauchen die lokale Rechenpower nun einmal.

Hier kommt Edge ins Spiel: Nur so können Unternehmen Schritt halten mit dieser Entwicklung.

Die Zukunft ist also gar nicht mehr so fern. Edge hat sich längst eine feste Rolle in unserem digitalen Ökosystem erobert. Spannend bleibt, welche kreativen Anwendungen die Dezentralisierung noch ermöglichen wird.

Eines ist sicher: Edge Computing wird unseren Alltag schon in wenigen Jahren viel stärker prägen als heute. Die Innovationen laufen bereits jetzt auf Hochtouren.