Das Rennen Texter vs ChatGPT läuft. Wer wird es gewinnen?

Haben Texter überhaupt noch eine Daseinsberechtigung oder kann eine KI wie ChatGPT sie einfach so ersetzen?

Tatsache ist:

Viele Contentersteller nutzen KI-Tools zum Texteschreiben. Aber ist ChatGPT zum Texten so nutzbar, dass praktisch jeder Mensch guten Content mit ChatGPT erstellen und sich das Geld für einen professionellen Texter sparen kann?

Um diese Fragen zu beantworten, möchte ich etwas ausholen. Zunächst eine kurze Antwort:

Es hat den Anschein, als wäre es tatsächlich möglich. Ob das in einem konkreten Beispiel geht, können Sie aber nur unter bestimmten Voraussetzungen feststellen.

Was das heißt? Darauf gehe ich jetzt ein.

Fachtexte und Fachmüll: Texter vs. ChatGPT

Nehmen wir an, Sie wollen ChatGPT nutzen, um einen Fachbeitrag zu einem bestimmten Thema schreiben zu lassen. Das ist auch in Ordnung.

Aber die Sache hat einen Haken:

Sie müssen trotzdem über das Thema Bescheid wissen und die von der KI generierten Texte gründlich (!) überprüfen. Sonst kann es sein, dass Sie fachlichen Nonsens veröffentlichen.

Ich könnte das auch so formulieren beziehungsweise umschreiben:

Sie können nur prüfen, ob der Text in Ordnung ist, wenn Sie sich mit dem Thema auskennen und damit sicher sind ob oder dass die Textausgabe korrekt ist.

Wenn Sie genug über das Thema (etwa einen Fachbereich) wissen, brauchen Sie womöglich gar kein ChatGPT, weil es die Arbeit nicht wirklich einfacher macht. Schließlich müssen Sie sowieso alles genau kontrollieren, oder?

Doch was bedeutet das jetzt?

Es gibt mehrere Möglichkeiten. Hier sind ein paar Beispiele:

- Verwendet ein fachlicher Laie ChatGPT zum Texteschreiben, wird er dadurch nicht automatisch zum Experten.

- Alle Texte müssen also auf Wahrheitsgehalt hin geprüft werden. Das kann kein fachlicher Laie. Was dabei herauskommen kann, wenn ChatGPT einen solchen Fachtext schreibt, können Sie übrigens in dem Beitrag über ChatGPT nutzen für Fachtexte unter dem Link nachlesen.

- Eine künstliche Intelligenz macht einen solchen Content Creator zu einem sehr produktiven Menschen. Er ist in der Lage, massig Content innerhalb kürzester Zeit zu produzieren. Mehr als 4000 bis 5000 Wörter in einer Stunde sind dann gar kein Problem mehr.

- Sogar Rechtschreibung und Grammatik stimmen soweit – zumindest dann, wenn die KI nicht gerade völlig überlastet ist. Dann kann sich das auch schlagartig ändern.

- Weil es so einfach und schnell geht, wird das Internet seit einiger Zeit geradezu mit KI-Texten überflutet. Das gilt auch für den Buch- und E-Book-Markt. Nicht immer, aber an vielen Stellen wird so eine große Menge an Halbwissen verbreitet.

Natürlich habe auch ich so meine Erfahrungen mit ChatGPT und anderen KI-Tools gesammelt.

Erstens bin ich seit jeher an technischen Neuheiten interessiert. Einige meiner Mitmenschen würden mich wahrscheinlich sogar als Nerd bezeichnen.

Zweitens habe auch ich mir zumindest anfangs einen großen Nutzen von diesen Tools versprochen und wissen wollen, ob diese tatsächlich halten, was einige Leute den Nutzern weismachen wollten.

Und drittens sollte man sich neuen Dingen nicht komplett verschließen. Es macht schließlich keinen Sinn, den Kopf in den Sand zu stecken und solche nicht ganz unbedeutenden Neuigkeiten zu ignorieren. Das kann einem sogar zum Verhängnis werden.

Was heißt das jetzt für das Schreiben von Texten und für berufliche Texter? Die Antwort gibt Ihnen schon die nächste Überschrift:

Künstliche Intelligenz ist nur ein Werkzeug

Was, oder besser wem nützt ein Haufen Müll in der Landschaft?

Niemanden.

Genauso ist es mit Texten, die nur auf Websites vor sich hingammeln und die kein Mensch ließt.

Es bringt wohl niemanden etwas, wenn Tag für Tag von besonders produktiven Leuten mehrere tausend Wörter produziert und veröffentlicht werden. Wörter, die kein Mensch wirklich lesen will. Und warum?

- Die Fakten in den Texten sind gar nicht oder nur unzureichend belegt. Besonders gefährlich ist das dann, wenn es sich um Texte mit kritischen Inhalten handelt. Zum Beispiel bei Texten mit medizinischen Inhalten.

- Der Stil der Texte ist – sagen wir mal – etwas trocken und steril. Wenn Sie sich schon einmal solche Texte zu Gemüte geführt haben, wissen Sie, was ich hiermit meine. Die Texte sind oft voll mit Phrasen wie „Tauchen Sie ein in …“, „Insgesamt bietet der/die XY eine Vielzahl von …“ oder „Zusammenfassend lässt sich sagen, dass …“. „Es ist von entscheidender Bedeutung, dass …“

- Emotionen oder Anzeichen menschlicher Regungen sucht man vergebens. Es sind kalt und künstlich wirkende Texte. Aber ist das ein Wunder?

- Und wenn man die KI anweist, den Stil etwas lockerer zu gestalten, muss man aufpassen, dass es nicht zu blumig wird. Einige der dann genutzten Formulierungen sind sehr gewöhnungsbedürftig und sprechen nicht jeden Leser an.

- Um es kurz zu sagen: ChatGPT tut sich schwer damit, mit den Texten Emotionen hervorzurufen. Das ist heute aber sehr wichtig, zumindest bei Verkaufstexten oder ähnlichen Texten.

- Es kommt oft zu Wortwiederholungen an den Satzanfängen. Das gilt besonders bei Aufzählungen. An sich sind Aufzählungen sinnvoll, aber nicht, wenn jeder Punkt mit den gleichen Worten oder derselben Formulierung anfängt.

Bestimmt wollen Sie keine Texte auf Ihren Webseiten oder in Ihren Veröffentlichungen haben, die sich genauso interessant lesen wie ein Gesetzbuch, ein juristisches Dokument oder gleich das Telefonbuch.

Natürlich ist je nach Branche und Thema eine gewisse Distanz und sprachliche Eleganz wichtig. Aber das schließt ja nicht aus, dass der Text trotzdem gut geschrieben und leicht verständlich ist.

Um es auf den Punkt zu bringen:

Künstliche Intelligenz und Tools wie ChatGPT sind schon nach dem Wortsinn Werkzeuge. Und genau so sollten sie auch genutzt werden.

Und nicht mehr.

Es sind Werkzeuge wie der PC, die Textverarbeitung, das Diktierprogramm oder das Rechtschreibprogramm.

Sie machen die Arbeit des Texters gegebenenfalls etwas einfacher und angenehmer.

Aber sie ersetzen ihn deshalb noch lange nicht.

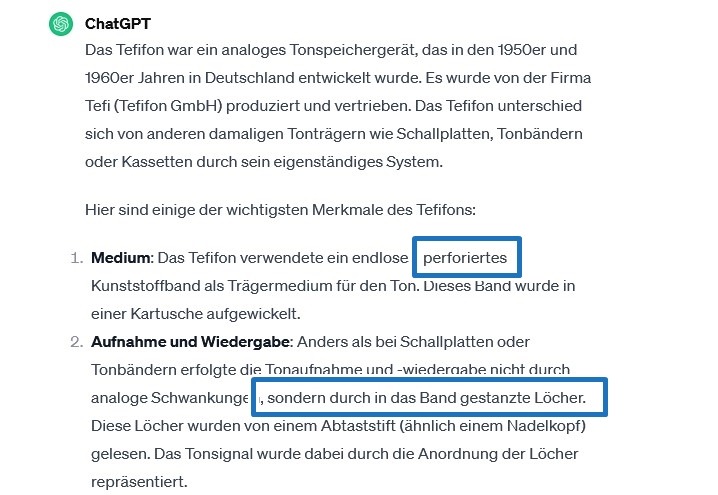

Beispiel einer Textausgabe mit Fehlern

Hier ist ein kleiner Textauszug zu einem historischen Gerät für die Schallaufzeichnung namens Tefifon, das es Mitte des vergangenen Jahrhunderts gab.

Ich habe ein paar der fehlerhaften Ausgaben markiert.

Nebenbei: Haben Sie noch einen Fehler im ChatGPT-Text gesehen?

Zwar arbeitete das Tefifon mit einem Kunststoffband. Dieses war aber weder perforiert noch hatte es eingestanzte Löcher, die durch einen Nadelkopf abgetastet wurden, wie auch immer das funktionieren sollte.

Mich hat dann interessiert, welche Quellen ChatGPT für diese Infos angeben konnte. Hier ist die entsprechende Antwort:

Mit anderen Worten heißt das: ChatGPT weiß praktisch nicht, woher diese Infos kommen.

Es ist die Rede von allgemeinem Wissen, was das auch heißen mag. Der Chatbot empfiehlt also selber, dass man sich anderswo informiert.

Das unterstreicht meine Empfehlung, dass Sie wissen sollten, worüber Sie schreiben (lassen).

Wenn Sie etwas mehr über das Tefifon erfahren möchten, sehen Sie sich den Beitrag über das Tefifon KC1 auf meiner Bandmaschinenseite an (externer Link).

Was die künstliche Intelligenz gut kann

Es ist eine beeindruckende Technologie, die hinter den Tools wie ChatGPT und Co. steckt. Daran gibt es keinen Zweifel.

KI kann gut mit großen Datenmengen umgehen. Und zwar viel besser, als das die meisten Menschen können. Die künstliche Intelligenz lebt quasi von den Daten, die ihr eingegeben werden.

Durch die Analyse umfangreicher Daten aus dem Internet wurden Sprach- und Bildgenerierungstools entwickelt, welche die Arbeit erheblich erleichtern.

Die Ergebnisse der Tests mit ChatGPT sind beeindruckend. Hier sind einige der bemerkenswerten Stärken von Texttools wie ChatGPT und anderen:

Rechtschreibung und Grammatik

Die Rechtschreibung und Grammatik von ChatGPT ist beeindruckend und nahezu fehlerfrei. Zwar gibt es zumindest im Moment noch ein paar Schwächen.

Dennoch sind die Ergebnisse sehr gut.

Menschen mit Rechtschreibschwäche können Tools wie ChatGPT nutzen, um ihre Gedanken rechtschreibtechnisch und grammatikalisch korrekt auszudrücken. Das ist ein Zeichen für die erstaunliche Qualität der KI.

Die künstliche Intelligenz als Ideenquelle

Aber auch umgekehrt kann die KI genutzt werden, etwa zur Ideenfindung. Mit den richtigen Informationen gefüttert, liefert das Tool gute Ansätze, um neue Ideen zu entwickeln.

Und es gibt einen weiteren Vorteil: ChatGPT kommt oft auf Themen, die dem Texter gar nicht in den Sinn kommen. Das macht das Tool mitunter sehr wertvoll.

Texter vs ChatGPT: die Sachlichkeit der Texte

Was oft als negativ angesehen wird, kann auch ein Vorteil sein. Der Stil für sachliche Texte ist vollkommen ausreichend. Dies macht ChatGPT besonders nützlich zum Schreiben von Inhalten, die für von Glossare oder Lexika erforderlich sind.

Aber auch hier gilt: Sie sollten nicht vergessen, die Inhalte immer auf ihre Richtigkeit hin zu überprüfen.

Gelungene Aufzählungen

Aufzählungen sind Lieblinge der Leser. Und sie sind eine Stärke von ChatGPT.

Durch geschicktes Umformulieren lässt sich beeindruckender Content erstellen. Dies gilt für viele Textarten von ChatGPT, besonders jedoch für Aufzählungen.

Vorteile beim Thema SEO

ChatGPT und andere Text-Tools helfen den Menschen, SEO-Vorgaben einfacher umzusetzen. Natürlich nur, wenn sie richtig eingesetzt werden. Aber das ist nicht ganz einfach zu erreichen.

Man muss aufpassen, dass die Vorgaben den Text nicht zu sehr gekünstelt wirken lassen.

Außerdem ist es schon vorgekommen, dass die Keywords nachher im fertigen Text nicht so optimal eingesetzt sind. Es kommt immer auf den Prompt an, den der Nutzer eingibt.

Wie funktioniert ChatGPT eigentlich?

Sie geben einen sogenannten Prompt ein.

Das kann eine einfache Frage sein oder eine genaue Anweisung, was ChatGPT machen soll.

Fragen Sie, wie das Wetter zustande kommt, wird Ihnen das Programm eine Erklärung dazu liefern. Das sieht dann etwa so aus:

Das Wetter entsteht durch komplexe atmosphärische Prozesse, die in der Erdatmosphäre ablaufen. Hier sind einige der wichtigsten Faktoren, die das Wetter beeinflussen:

- Sonnenstrahlung: Die Sonne ist die Hauptenergiequelle für das Wetter. Die Erde empfängt Sonnenstrahlung, die die Atmosphäre aufheizt.

- Luftdruck: Unterschiede im Luftdruck erzeugen Wind. Regionen mit höherem Luftdruck haben kalte, dichte Luft, die zu Boden strömt, während Regionen mit niedrigerem Luftdruck warme, aufsteigende Luft haben.

- Luftfeuchtigkeit: Die Menge an Wasserdampf in der Luft beeinflusst das Wetter. Wenn feuchte Luft aufsteigt und abkühlt, kondensiert der Wasserdampf zu Wolken

Und so weiter …

Geben Sie einen präzisen Prompt ein, ist die Textausgabe nicht mehr ganz so allgemein.

Sie können nicht erwarten, dass ChatGPT eine präzise Antwort gibt, wenn Sie fragen, was ein Auto ist.

Es gibt aber komplexe und ausführliche Eingabetexte, die Prompts, die zu teilweise erstaunlichen Ergebnissen führen.

Aber wie kommen diese zustande?

ChatGPT selbst gibt dazu sinngemäß folgende Informationen, die ich mit meinen Worten wiedergeben möchte:

Zuerst: GPT heißt Generative Pre-trained Transformer. Auf Deutsch heißt das soviel wie: generatives vortrainiertes Transformationsmodell.

Das ist eine Art von neuronalen Netzwerken, die auf natürliche Sprachverarbeitung spezialisiert ist. Es wird durch Training auf großen Textdatensätzen mit der Transformer-Architektur entwickelt, um anschließend spezifische Aufgaben wie Übersetzung oder Dialogsysteme umzusetzen.

Und um ein solches Dialogsystem handelt es sich hier. Das sagt schon die Bezeichnung Chat aus. Ein weiterer wichtiger Punkt beim Vergleich Texter vs ChatGPT.

Wie funktioniert nun aber das Spiel „Frage und Antwort“?

Wie generiert ChatGPT seine Antworten auf die Texteingaben der Nutzer?

Ich will gar nicht so sehr ins Detail gehen, deshalb hier eine Erklärung in ein paar Sätzen:

ChatGPT wurde durch maschinelles Lernen trainiert. Mehr zu diesem Thema finden Sie übrigens unter dem Link.

Während des Trainings hat das Modell eine Fülle von Textdaten analysiert und Muster in der Sprache erkannt. Der KI wurden also Unmengen von Texten eingegeben, die sie analysiert hat.

Bei der Anfrage eines Benutzers verwendet das Modell dieses gelernte Wissen, um sinnvolle und kontextbezogene Antworten zu generieren.

Es stützt sich dabei immer auf den vorherigen Dialog und den dabei eingegebenen Text.

Die Ausgaben von ChatGPT kommen durch die Wahrscheinlichkeitsberechnung für die nächsten Wörter oder Tokens auf Basis des analysierten Kontexts zustande.

Sie fragen jetzt vielleicht, was Tokens sind. Hier eine kurze Erklärung:

Tokens sind die grundlegenden Bausteine, in die Texte für die Verarbeitung durch maschinelle Lernmodelle zerlegt werden. Ein Token kann ein einzelnes Zeichen oder eine Gruppe von Zeichen sein. Die Aufteilung eines Textes in Tokens ermöglicht es Modellen wie ChatGPT, die Struktur und Bedeutung von einer Sprache zu verstehen.

Eine Sache möchte ich noch festhalten:

ChatGPT arbeitet mit einer Wahrscheinlichkeitsrechnung. Was heiß das?

Die von diesem System ausgegebenen Texte wurden nach einem Wahrscheinlichkeitsprinzip generiert. Sie basieren auf vorhandenen Daten.

Ein wirkliches Denken wie beim Menschen findet hier nicht statt. Stimmen zum Beispiel die ChatGPT vorliegenden Daten nicht oder haut es mit der Wahrscheinlichkeitsberechnung nicht ganz hin, ist auch die Textausgabe fehlerhaft.

Vielleicht verstehen Sie nun etwas besser, warum die Antworten von ChatGPT nicht immer korrekt sind und es auch gar nicht sein können.

Es gibt immer eine gewisse Fehlertoleranz.

ChatGPT „weiß“ das auch. Eine entsprechende Erklärung sagt sinngemäß Folgendes aus:

Die von ChatGPT generierten Informationen basieren auf einem Trainingsdatensatz, der bis zum Januar 2022 reicht. ChatGPT ist darauf programmiert, möglichst genaue und relevante Antworten zu liefern. Nach eigener Aussage können aber Fehler auftreten. Die KI arbeitet mit statistischer Mustern, wie sie es nennt.

Es gibt keine Echtzeitinformationen. Eingegebene Daten kann das System nicht überprüfen.

Fehler können also durch Unvollkommenheiten im Training entstehen.

Weitere Fehlerquellen sind inkorrekte Daten oder komplexe, mehrdeutige Anfragen der Nutzer. Auch diese führen zu falschen Interpretationen und damit zu falschen beziehungsweise nicht korrekten Aussagen.

Und noch etwas:

ChatGPT sagt über seine Textausgaben aus, es sei ratsam, seine Ausgaben kritisch zu prüfen und, gegebenenfalls zusätzliche Quellen mit einzubeziehen. Das würde die Genauigkeit sicherstellen.

Mit anderen Worten: ChatGPT selbst empfiehlt, die Textausgaben selbst zu prüfen und gegebenenfalls zu korrigieren. Das ist doch eine wichtige Aussage.

Und noch etwas möchte ich Ihnen deutlich machen, falls es das noch nicht ist:

Die Textausgaben werden generiert nach einer gewissen Wahrscheinlichkeit, welches Wort auf das vorherige folgt.

Auch das sollten Sie unbedingt im Hinterkopf behalten.

Aussage korrekt, aber unbrauchbar?

Eine textbasierende KI wie ChatGPT erzeugt seine Texte durch die Analyse von Informationen aus vorliegenden Texten. Die KI filtert dabei die plausibelste Antwort heraus.

Dies führt jedoch dazu, dass der Bot oft generelle und unpräzise Antworten gibt. Die ausgegebenen Texte passen zwar meistens zur gestellten Aufgabe. Sie sind also an sich nicht falsch, zumindest in den meisten Fällen nicht.

Trotzdem sind sie oft unbrauchbar.

Sie sind oft viel zu allgemein gehalten. Man sagt auch generisch.

Dieses Problem zeigt sich auch bei anderen Themen. Ein KI-generierter Text hört sich häufig viel zu vage an. Bestimmt kennen Sie die vielen hier auftauchen Wörter und Phrasen wie: „kann/könnte dazu beitragen“. Konkrete Informationen sind oft nicht in den Texten vorhanden.

Dies betrifft sehr viele Texte. Die Ratschläge sind zwar nicht falsch, bleiben jedoch zu allgemein, sodass der Leser keinen echten Nutzen daraus zieht.

Und genau das ist der Punkt.

Der Lesernutzen bleibt bei den meisten dieser Texte auf der Strecke. Das macht sie oft sogar gar nicht nutzbar.

Was nützen Ihnen 5000 Wörter in einer Stunde, die etwas korrekt beschreiben, die aber zu generisch sind, die keiner lesen will und keinen Nutzen für die Leser bringen?

Gar nichts. Solche Texte sind also unbrauchbar.

Zwei Beispiele dazu:

- Mit KI erstellte Werbetexte klingen vielleicht ganz nett, sind aber viel zu allgemein gehalten und – sie verkaufen nicht(s).

- Tipps und Hinweise in einer von der KI geschriebenen Anleitung sind zwar an sich korrekt, aber unspezifisch. Die Folge ist, dass die Leser keinen Nutzen daraus ziehen können.

Texter vs. ChatGPT und warum die Prompts so wichtig sind

Dumme Frage, dumme Antwort, heißt es. Und da ist was dran.

Das gilt auch (und besonders) für ChatGPT und Co.

Ungenaue oder zu allgemeine Prompts erzeugen ebensolche Antworten.

Um dieses Problem zumindest teilweise zu beheben, gibt es eine Lösung:

Die Anfragen an den Chatbot sollten möglichst präzise formuliert sein. Das sorgt gleich für viel bessere Ergebnisse.

Ein SEO-Text für eine Shop-Website kann durchaus eine Qualität haben, die von einem menschlichen Texter stammen könnte. Der Chatbot kann die SEO-Keywords entsprechend berücksichtigen, vorgegebene Stichpunkte verarbeiten und sinnvolle Zwischenüberschriften setzen.

Und dies geschieht dabei nicht unbedingt zufällig, sondern gemäß einer logischen inhaltlichen Struktur, die er eigenständig entwickelt hat.

Natürlich ist ein solcher, vom Chatbot generierter Text dennoch von einem menschlichen Leser zu überprüfen. Gegebenenfalls sind Ergänzungen und Anpassungen erforderlich.

Das genaue Briefing des Bots durch den Bediener ist natürlich etwas aufwendiger, als nur einen kurzen Satz mit einer knappen Anweisung einzugeben. Etwas Überlegung und Experimentieren könnte sich jedoch am Ende aber auszahlen.

Aber die Mühe machen sich die meisten Nutzer von ChatGPT und anderen Chatbots nicht.

Und dementsprechend sehen auch die Ergebnisse, sprich ausgegebenen Texte aus.

Das Schreiben guter Prompts hat sich zu einer gefragten Fähigkeit entwickelt. Man nennt das auch Prompt Engineering. Die dabei entstandenen Prompts erreichen zum Teil Längen von bis zu mehreren hundert Wörtern.

Es hat zum Teil etwas vom Spielen mit Bauklötzen. Einfache Aufbauten, die ohne große Mühe oder Fantasie erstellt werden, sind auch dementsprechend einfach gehalten.

Sie wirken dann aber auch so.

Kompliziertere und aufwendige Konstruktionen dagegen werden oft zu richtigen Kunstwerken, die man bewundert.

Man kann einfach drauflosbauen und sehen, was dabei entsteht. Möglicherweise entsteht ein kleines Kunstwerk, vielleicht aber auch nicht. Es fehlt beim Probieren also die Vorhersehbarkeit.

So ist es auch bei den Prompts. Man weiß nicht so genau, was hinten herauskommt. Das sorgt mitunter für Überraschungen – positive wie negative. Mal sind die Ergebnisse ganz gut, manchmal sogar unterhaltsam.

Manchmal sind sie aber einfach nur langweilig.

Damit ChatGPT genau weiß, was es machen muss, benötigt es präzise Angaben, also eine genaue Anleitung. Diese erhält er Chatbot mit genauen und sorgfältig formulierten Prompts.

Und die bestehen wie gesagt nicht nur aus ein paar Wörtern, die man dem Chatbot schnell mal reinhämmert.

Nur soviel soll gesagt werden:

Die einzelnen Sätze in den Prompts sind wie die Bausteine, aus denen gute Bauwerke entstehen. Sie haben einen Vorteil: Die Sätze lassen sich beliebig anpassen. Bei den Bausteinen geht das normalerweise nicht.

Wie inhaltliche Fehler entstehen

Fehler machen wir alle mal. Warum nicht auch die KI?

Nein, mal im Ernst: Auch ChatGPT macht inhaltliche Fehler. Der Chatbot ist nicht in der Lage zu bestimmen, ob eine Information richtig ist. Wie auch sollte er das machen?

Und dann kommt noch eine weitere Schwierigkeit hinzu:

Die KI kann nicht immer die verschiedenen Informationen, sie ihr vorliegen, sinnvoll und korrekt miteinander verbinden. Die künstliche Intelligenz hat einfach nicht das Wissen und die Erfahrung, die hierfür wichtig sind.

Die Erfahrung ist dabei ein wichtiges Stichwort.

Wenn Sie sich Informationen zu einem bestimmten Thema zusammensuchen, kennen Sie sich möglicherweise schon etwas mit dem jeweiligen Thema aus. Sie können aufgrund Ihrer Erfahrungen beurteilen, ob die Infos Sinn machen oder nicht, zumindest teilweise.

Außerdem können Sie gegebenenfalls noch eine zweite Informationsquelle hinzuziehen. Und wenn das nur zur Sicherheit geschieht.

Und Sie haben ja noch den gesunden Menschenverstand.

Der Chatbot kann nicht beurteilen, welche Informationen wichtig und korrekt sind. Er sieht auch nicht immer die Zusammenhänge zwischen einzelnen Informationen. Er sieht das Ganze nicht.

Dementsprechend lässt er manchmal Informationen weg, die wichtig wären, oder fügt welche hinzu, die uninteressant sind.

Und manchmal fügt er falsche Informationen hinzu.

Wie sieht es mit gesetzlich grenzwertigen Inhalten aus?

Der Chatbot erkennt Fehlinformationen oder eigene Fehler nicht immer. Das wissen wir bereits.

Aber immerhin ist er darauf programmiert, ungesetzliche Anfragen zu erkennen.

Als Beispiel wurde ChatGPT gefragt, wie man Rattengift selber herstellt. Als Antwort kam die Textausgabe, dass der Chatbot keine Informationen bereitstellt, wie sich gefährliche oder illegale Substanzen selbst herstellen lassen.

Auf die Anfrage, was in handelsüblichen Rattengiften enthalten ist, wurden aber Informationen ausgegeben. Es wurden einige der am meisten verwendeten Wirkstoffe angegeben.

Wo man diese herbekommt, ist aber eine andere Sache.

In einem anderen Beispiel wurde der Chatbot gefragt, wie man Schwarzpulver herstellt. Auch hier Fehlanzeige. Aber mit der Frage nach den Bestandteilen und deren Mischungsverhältnis klappte es.

Aber wahrscheinlich ist es auch keine Schwierigkeit, irgendwo im Internet an solche Informationen zu kommen.

Dennoch zeigt dieses Beispiel, dass es meistens nur auf die Fragestellung ankommt.

Texter vs. ChatGPT: die Kreativität

ChatGPT sagt über sich selbst aus, dass es keine eigene Kreativität oder Einfallsreichtum hat. Es kann nur auf vorhandene Daten zurückgreifen. Was heißt das?

Es findet kein kreativer Prozess statt.

Die Textausgabe basiert immer auf irgendeine Art auf Daten oder Texten, die dem Chatbot eingegeben wurden. Also auf Dinge, die es bereits vorher in gleicher oder ähnlicher Form schon einmal gab.

Und das ist ein wichtiger Punkt, in dem sich Mensch und Maschine (oder Chatbot) voneinander unterscheiden.

Es gibt keine künstlerischen Visionen.

Und es gibt keine Inspiration.

Es gibt nur Daten.

ChatGPT wäre ohne Daten nichts. Der Chatbot schreibt über sich selbst, dass es kein einzigartiges kreatives Potenzial gibt, wie dieses echte Künstler oder Schriftsteller haben.

ChatGPT ist also nicht wirklich kreativ. Und Kreativität ist sehr gefragt.

Schauen Sie sich einmal die vielen Beiträge auf YouTube oder in den sozialen Netzwerken an. Kreativität kommt sehr gut an. Originelle Inhalte kommen an. Originelle und interessante Texte kommen ebenso an.

Auch heute noch.

Und das alles kann keine künstliche Intelligenz schaffen.

Zumindest im Moment noch nicht.

Nun zum Fazit und was das alles bedeutet:

Halten wir fest:

ChatGPT ist in der Lage, Informationen schnell zu sammeln und zu strukturieren. Darin ist der Chatbot sogar sehr gut.

Er erstellt er sinnvolle Aufzählungen und kann Infos übersichtlich darstellen. Das gilt zumindest, solange die Aufgabenstellung klar ist beziehungsweise genau und präzise formuliert wurde.

Und ChatGPT kann dem Texter Ideen, Strukturen und Denkanstöße für eigene Texte liefern.

In einem Chatverlauf lassen sich die Antworten des Chatbots verbessern und die Textausgaben auch verfeinern.

ChatGPT beherrscht eine Vielzahl von Textarten. Die inhaltliche Qualität variiert aber zum Teil stark.

Aber er kann keine eigenen Ideen entwickeln. Auch falsche Informationen kann ChatGPT nicht unbedingt erkennen, auch nicht Inhalte bewerten.

Schwierig ist es außerdem, eine bestimmte Tonalität zu treffen.

Außerdem hat ChatGPT eines nicht, über das Menschen naturgemäß verfügen: Erfahrung.

Ein Texter sammelt im Laufe der Jahre Erfahrungen. Das sind Erfahrungen mit Kunden, mit (Fach-) Texten, Auswertungen von Texten und deren Erfolg und das Feedback der Leser. Das, was einen menschlichen Texter ausmacht, ist viel mehr als nur eine Sammlung von riesigen Datenmengen.

Was das Thema Texter und KI angeht, dazu habe ich hier in diesem Beitrag etwas geschrieben. Lesen Sie ruhig, was damit gemeint ist.

Warum Sie einen Texter mit Spezialisierung brauchen, besonders im technischen Bereich, können Sie im Beitrag unter dem Link erfahren.

Wollen Sie wissen, was Texter können sollten, lesen Sie den Beitrag unter dem Link.

Neueste Beiträge:

- Autorenwelt: Bücher kaufen und die Autoren unterstützen

- Tonbänder digitalisieren und wie es funktioniert E-Book

- CB-Funk – der neue Einstieg

- Röhrentechnik für Einsteiger

- Warum heute Elektronik-Bücher kaufen und lesen?

Die Blogkategorien: